آیا گوگل تمام صفحاتی که در وب سایت شما تولید و منتشر میشود ایندکس کرده رتبه بندی میکند؟ خب، لزوما خیر! در واقع، دادهها نشان میدهند که گوگل حدود نیمی از صفحات وب سایتهای بزرگ را کراول نمیکند. برای اینکه یک صفحه در نتایج جستجو نشان داده شود و سایت شما ترافیک به دست آورد، ابتدا گوگل باید در آن صفحه بخزد. به قول خود گوگل، "خزیدن (کراول کردن) نقطه ورود سایتها به نتایج جستجوی گوگل است." از آنجایی که گوگل زمان و منابع نامحدودی برای خزیدن دائمی هر صفحه در وب ندارد، همه صفحات کراول نمیشوند و این همان چیزی است که سئوکاران از آن با عنوان بودجه خزش (Crawl Budget) یاد میکنند.

در این مقاله قصد داریم درباره اهمیت و نحوه بهینه کردن بودجه خزش صحبت کنیم؛ موضوعی که میتواند تاثیر به سزایی در رشد وب سایت و در نهایت کسب و کار اینترنتی شما داشته باشد.

بودجه خزش (Crawl Budget) چیست؟

بودجه خزش (Crawl Budget) حداکثر تعداد صفحاتی است که یک موتور جستجو میتواند و میخواهد در یک وبسایت مشخص بخزد یا به عبارتی کراول کند. گوگل بودجه خزش را با احتساب محدودیت نرخ خزش و تقاضای خزش تعیین میکند.

- محدودیت نرخ خزش: سرعت صفحات شما، خطاهای خزیدن، و محدودیت خزیدن که در کنسول جستجوی گوگل تعیین میشوند (صاحبان وب سایتها میتوانند خزیدن بات های گوگل را در سایت خود کاهش دهند) همگی میتوانند بر محدودیت سرعت خزش تأثیر بگذارند.

- تقاضای خزش: محبوبیت صفحات شما و همچنین تازگی یا قدیمی بودن آنها میتواند بر تقاضای خزش تأثیر بگذارد.

تاریخچه بودجه خزش

در سال 2009، گوگل اذعان کرد که تنها درصدی از محتوای آنلاین را میتواند پیدا کند و مدیران وبسایتها را تشویق کرد تا بودجه خزش خود را بهینهسازی کنند.

طبق گفته گوگل، «اینترنت فضای بزرگی است. محتوای جدید پیوسته در حال تولید است. گوگل تعداد منابع محدودی دارد، بنابراین وقتی با حجم تقریباً بی پایان محتوای آنلاین قابل دسترس مواجه میشویم، باتهای گوگل (Googlebot) فقط میتوانند درصدی از آن محتواها را پیدا کنند و در آنها بخزند. و بعد، از محتوایی که کراول شدهاند، فقط میتوانیم بخشی از آنها را فهرست کنیم.»

این موضوع یه یکی از دغدغههای سئوکارها و وب مسترها تبدیل شد و صحبت در مورد بودجه خزش آنقدر بالا گرفت که باعث شد گوگل در سال 2017 پستی را منتشر کند که «بودجه خزش برای Googlebot به چه معناست». در این پست گوگل توضیح میدهد که چگونه در مورد بودجه خزش فکر میکند و چگونه آن را محاسبه مینماید.

آیا باید نگران بودجه خزش باشیم؟

اگر وب سایت کوچکی دارید احتمالا بودجه خزش نباید باعث نگرانی شما باشد. به گفته گوگل، «بودجه خزش چیزی نیست که اکثر ناشران نگران آن باشند. اگر سایتی کمتر از چند هزار URL داشته باشد، در بیشتر مواقع به طور موثر کراول میشود.»

با این حال، اگر روی وبسایتهای بزرگ کار میکنید، بهویژه آنهایی که به طور خودکار صفحات را بر اساس پارامترهای URL تولید میکنند، ممکن است بخواهید فعالیتهایی را اولویتبندی کنید که به گوگل کمک میکند تا بفهمد چه چیزی را و چه زمانی باید کراول کند.

چگونه بودجه خزش خود را بررسی کنیم؟

چه صاحب یک وب سایت کوچک هستید و چه روی سایتی کار میکنید که هزاران صفحه و URL دارد، به جای اینکه به حرفهای گوگل توجه کنید، بهتر است خودتان بررسی کنید و ببینید که آیا مشکل بودجه خزش دارید یا خیر. بهترین راه برای بررسی بودجه خزش و کشف اینکه آیا گوگل همه صفحات شما را کراول کرده یا برخی را از قلم انداخته است این است که تعداد کل صفحات در معماری سایت خود را با تعداد صفحات خزیده شده توسط Googlebot مقایسه کنید.

این کار به یک خزنده (کراولر) سایت و همچنین یک تحلیلگر فایل گزارش یا Log File نیاز دارد.

استفاده از تحلیل لاگ با تقسیم بندی URLها

از فایلهای گزارش خود میتوانید دریابید که گوگل در هر ماه چه تعداد از URL های سایت شما را کراول کرده است. این همان بودجه خزش گوگل شما است.

فایلهای گزارش خود را با خزش کامل سایت ترکیب کنید تا بفهمید بودجه خزش شما چگونه خرج میشود. این داده ها را بر اساس نوع صفحات تقسیم بندی کنید تا مشخص شود کدام بخش از سایت شما توسط موتورهای جستجو و با چه فرکانسی کراول میشود.

همچنین، متوجه خواهید شد که مهمترین بخشهای سایت شما چگونه کراول میشوند.

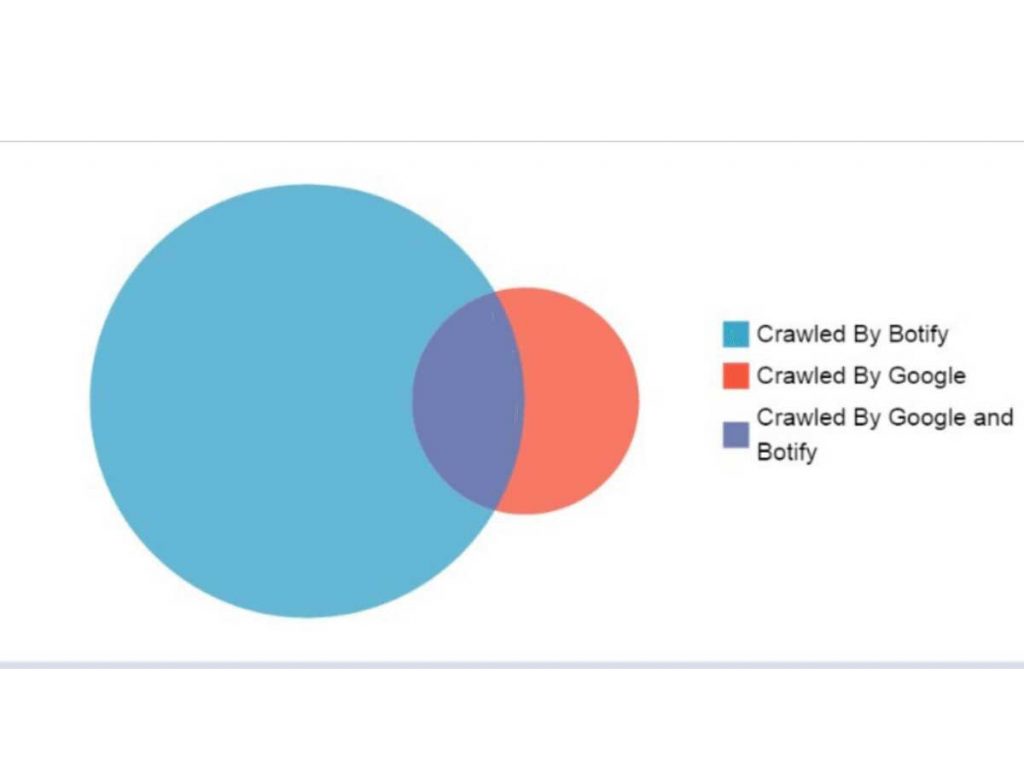

استفاده از نمودار Crawls Venn

یکی از بهترین راهها برای اینکه نسبت صفحات کراول شده را در مقابل صفحاتی که بات گوگل آنها را کراول نکرده است بفهمیم، استفاده از نمودار Crawls Venn است.

دو دایرهای که در این نمودار ون میبینید یکی صفحاتی در معماری سایت شما است (فقط توسط Botify کراول شده)، و دیگری صفحات خارج از معماری سایت شما است (فقط توسط Google کراول شده، و با عنوان "صفحات یتیم" نیز شناخته میشود) و نقطه مشترک آنها صفحاتی را نشان میدهد که هم توسط Google و هم Botify کراول شدهاند.

صفحاتی که توسط Google کراول میشوند، تنها زمانی که نوبت به بودجه خزش شما میرسد، فضای ممکن برای بهبود را نشان میدهند. اگر این صفحات به هیچ جایی از وب سایت شما پیوند داده نشدهاند، اما گوگل همچنان آنها را پیدا کرده و در آنها میخزد، به این معنی است که احتمالا بخشی از بودجه خزش شما در حال هدر رفتن است.

نسبت خزش در سایتهای مختلف به طور چشمگیری متفاوت است. در صنایع و حوزههای مختلف، برای سایتهای بهینه نشده، به طور متوسط تنها 40 درصد از URL های استراتژیک هر ماه توسط گوگل کراول میشوند. 60٪ باقیمانده همان صفحات یک وب سایت هستند که به طور منظم کراول نمیشوند، در نتیجه به طور بالقوه ایندکس نیز نشده یا در صفحات نتایج جستجو (SERPs) به جستجوگران نشان داده نمیشوند.

با همین روش میتوانید بودجه خزش خود را اندازه گیری و بهینه سازی کنید.

بهینه سازی بودجه خزش چیست؟

بهینه سازی بودجه خزش فرآیندی است که به Googlebot و سایر موتورهای جستجو کمک میکند تا محتوای مهم شما را کراول و فهرستبندی کنند.

برای بهینه سازی بودجه خزش سه راه اصلی وجود دارد:

- دور نگه داشتن گوگل و سایر موتورهای جستجو از صفحاتی که نمیخواهید ایندکس شوند.

- به گوگل و سایر موتورهای جستجو کمک کنید مطالب مهم شما را سریعتر پیدا کنند.

- محبوبیت و تازگی صفحات مهم وب سایت خود را افزایش دهید.

اجازه دهید ببینیم که در عمل این رویه دقیقا به چه صورت انجام میشود.

چگونه بودجه خزش خود را بهینه کنیم؟

بهینه سازی بودجه خزش میتواند به همان اندازه که به افزایش بودجه خزیدن شما مربوط میشود (یعنی وادار کردن گوگل به صرف زمان بیشتری در سایت شما)، همان اندازه نیز باعث شود که گوگل مدت زمانی را که قبلاً به خزیدن در سایت شما اختصاص میداده است، حالا عاقلانهتر و بهینهتر صرف کند.

این بهینه سازی میتواند شامل موارد زیر شود:

- جلوگیری از خزیدن گوگل در URL های غیر متعارف (non-canonical URLs) وب سایت شما

- بهبود زمان بارگذاری صفحه با بهینه سازی جاوا اسکریپت

- به حداقل رساندن خطاهای خزیدن و کد وضعیت non-200

- بررسی محدودیت نرخ خزیدن در Google Search Console

- افزایش محبوبیت صفحات

- تازه کردن و به روز رسانی مطالب قدیمی و بدون بازدید

در ادامه این موارد را تک به تک بررسی میکنیم.

1- جلوگیری از خزیدن گوگل در URL های غیر متعارف (non-canonical URLs) وب سایت شما

تگهای کنونیکال (canonical) یا متعارف به گوگل میگویند که کدام نسخه از یک صفحه، نسخه اصلی و ترجیحی شما است.

به عنوان مثال، فرض کنید یک صفحه دسته بندی محصول برای «شلوار جین زنانه» دارید که در /clothing/women/jeans قرار دارد، و آن صفحه به بازدیدکنندگان اجازه میدهد تا بر اساس قیمت محصولات مختلف را مرتب کنند: از قیمت پایین به بالا (یعنی پیمایش وجهی).

با تغییر قیمت ممکن است این URL به /clothing/women/jeans?sortBy=PriceLow تغییر کند. تغییر یک فیلتر برای نمایش محصولات به ترتیب قیمت باعث تغییر در محتوای این صفحه نمیشود. بنابراین قطعا نمیخواهید /clothing/women/jeans?sortBy=PriceLow و /clothing/women/jeans هر دو ایندکس شوند.

در این موارد، اصولا یک برچسب متعارف (تگ کنونیکال) به /clothing/women/jeans?sortBy=PriceLow اضافه میکنید تا نشان دهد /clothing/women/jeans نسخه اصلی آن صفحه است و نسخه دیگر تکراری است. همین مورد در خصوص پارامترهای URL که به عنوان شناسه بخش اضافه شدهاند نیز صادق است.

شما به راحتی میتوانید تشخیص دهید که گوگل چه زمانی را صرف خزیدن صفحات غیر متعارف (non-canonical) با نشانگر غیرقابل ایندکس میکند. در بسیاری از سایتهای فروشگاهی صفحات غیرمتعارفی که قابل خزیدن برای گوگل هستند وجود دارد. این صفحات بودجه خزش را به کلی هدر میدهند.

یکی دیگر از نتایج احتمالی حذف انبوهی از URLهای غیر متعارف و ممانعت از خزش باتهای گوگل در آنها این است که صفحات بیشتری را میتوان به دفعات بیشتر کراول کرد. صفحاتی که بیشتر کراول میشوند، ترافیک بیشتری نیز دریافت میکنند.

گوگل این مشکل هدر رفتن بودجه خزش را سالها پیش گوشزد کرد، اما همچنان این معضل بزرگ برای سئو وجود دارد.

راه حل این معضل چیست؟

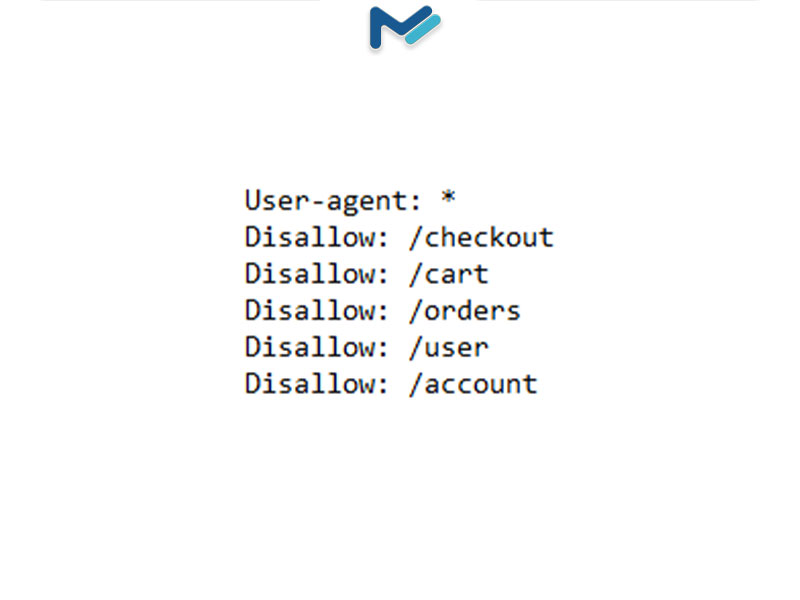

از فایل robots.txt خود استفاده کنید تا به موتورهای جستجو بگویید چه چیزهایی را کراول نکنند. هدر دادن منابع سرور در این نوع صفحات باعث میشود خزیدن باتها در صفحاتی که واقعاً دارای ارزش هستند کمتر شود و این امر ممکن است مانع کشف محتوای عالی شما توسط گوکل شود یا خزیدن باتها را به تاخیر بیاندازد.

با استفاده از فایل robots.txt سایت خود می توانید به باتهای موتور جستجو بگویید که چه چیزی را کراول کنند و چه چیزی را نادیده بگیرند. فایل robots.txt در ریشه وبسایتها قرار دارد و محتوای آن چیزی مثل شکل زیر است:

برای اطلاعات بیشتر در مورد ایجاد فایلهای robots.txt میتوانید اسناد گوگل را ببینید.

اما چگونه این فایل به حفظ بودجه خزش شما کمک میکند؟ در مورد مثالی که درباره "شلوار جین زنانه" و نرتب کردن صفحه محصولات بر حسب قیمت زدیم، شما میتوانید از robots.txt خود استفاده کنید تا موتورهای جستجو را از خزیدن در صفحات تکراری منع کنید. قطعا نمیخواهید موتورهای جستجو وقت خود را برای آنها تلف کنند زیرا به هر حال نمیخواهید این صفحات در فهرست گوگل قرار بگیرند.

وب سایتهای بزرگ با کاهش صفحات قابل ایندکس خود بودجه خزش را بهینه میکنند و ترافیک صفحات ارزشمند را افزایش میدهند. فایل robots.txt شما میتواند گام مهمی برای هدایت موتورهای جستجو از محتوای بی اهمیت به سمت محتوای مهم شما باشد.

البته باید به این نکته نیز توجه داشته باشید که اجازه ندادن به موتورهای جستجو برای کراول کردن برخی بخشها یا صفحات خاص تضمین نمیکند که موتورهای جستجو آن صفحات را ایندکس نکنند. اگر پیوندهایی به آن صفحات در جای دیگری وجود داشته باشد، مانند محتوا یا نقشه سایت، موتورهای جستجو ممکن است باز هم آنها را پیدا و فهرست کنند. در بخشهای بعدی بیشتر در این مورد صحبت خواهیم کرد.

2- بهبود زمان بارگذاری صفحه با بهینه سازی جاوا اسکریپت

اگر وب سایت شما زیاد از جاوا اسکریپت استفاده میکند، ممکن است بودجه خزش برای فایلهای جاوا اسکریپت و فراخوانی API هدر برود.

به این مثال دقت کنید. یک مشتری که صاحب یک وب سایت سازمانی بزرگ بود، رندر سمت مشتری را به رندر سمت سرور (SSR) تغییر داد. تقریباً بلافاصله، از تجزیه و تحلیل فایل لاگ دریافتیم که گوگل زمان بیشتری را صرف محتوای حیاتی وبسایت میکند. از آنجایی که گوگل صفحه کاملا بارگذاری شده را از سرور دریافت میکرد، نیازی به صرف زمان برای فایلهای جاوا اسکریپت و فراخوانی API نبود.

با اینکه جاوا اسکریپت تنها چیزی نیست که میتواند به کاهش زمان بارگذاری صفحه منجر شود، اما اغلب چند ثانیه زمان بارگذاری صفحه را افزایش میدهد. از آنجایی که "سرعت یا کندی بارگذاری صفحات" معیاری است که گوگل در بودجه خزش از آن استفاده میکند (و از نظر سئویی نیز بسیار مهم است)، استفاده زیاد از جاوا اسکریپت میتواند عامل مهمی باشد تا گوگل محتوای مهم و ارزشمند شما را نادیده بگیرد.

راه حل این معضل چیست؟

بار رندر جاوا اسکریپت را از موتورهای جستجو بردارید. تغییر رندر به سمت سرور (SSR) یا یک راه حل رندر پویا مانند SpeedWorkers میتواند باتهای موتور جستجو را آزاد کند تا زمان بیشتری را در صفحات مهم شما بگذرانند زیرا آنها دیگر مجبور نیستند، زمانی که از صفحات شما بازدید میکنند، وقت خود را صرف رندر جاوا اسکریپت کنند.

سرعت صفحه یکی از مولفههای تجربه کاربری و یک عامل مهم در رتبهبندی گوگل است، اما به یاد داشته باشید، سرعت صفحه یک عامل بودجه خزش نیز هست. اگر روی سایت بزرگی کار میکنید که از جاوا اسکریپت استفاده میکند، به خصوص اگر محتوا مرتباً تغییر میکند، ممکن است لازم باشد محتوای خود را از پیش برای باتهای موتور جستجو رندر کنید.

3- به حداقل رساندن خطاهای خزیدن و کد وضعیت non-200

یکی از معیارهایی که به گوگل کمک میکند تا تعیین کند چقدر زمان در سایت شما صرف کند این است که "آیا خزنده با خطا مواجه شده است یا نه؟"

اگر Googlebot هنگام خزیدن سایت شما با خطاهای زیادی مانند خطای سرور 500 مواجه شود، ممکن است محدودیت نرخ خزیدن شما و در نتیجه بودجه خزش شما را کاهش دهد. اگر متوجه حجم بالایی از خطاهای 5xx شدید، شاید لازم باشد که به دنبال بهبود قابلیتهای سرور خود بروید.

اما کدهای وضعیت non-200 نیز میتوانند به سادگی تلفات ایجاد کنند. چرا وقت گوگل را برای خزیدن در صفحاتی که حذف یا ریدایرکت کردهاید تلف میکنید، در حالی که میتوانید همین زمان را فقط به URLهای زنده و موجود خود اختصاص دهید؟

موردی داشتیم که یک وب سایت کوچک (که کمتر 100 هزار صفحه منتشرشده داشت) هنگام خزش باتها در سایتش، سهم نسبتا بالایی در کدهای واکنشی non-200 داشت (میانگین 40 درصد). اما یک روز، باگی در آن به وجود آمد که باعث میشد URLهای ناقصی که قبلا دیده نمیشدند کراول شوند. این URLهای خراب در نهایت 90 درصد از بودجه خزش را مصرف کردند.

الگوی URLهای ناقص شناسایی شد و با استفاده از تقسیمبندی URL بهعنوان «خطا» به رنگ زرد، آنها را برچسبگذاری کردند. با این کار توانستند تاثیر این URLهای خراب را بر سایر قسمتهای سایت درک کنند. در واقع، گوگل تمام وقت خود را صرف URLهای خطا میکرد و صفحات واقعی و ارزشمند این سایت را از قلم میانداخت.

راه حل این معضل چیست؟

پیوندهای داخلی خود را تمیز کنید و مطمئن شوید نقشه سایت XML شما به روز است. علاوه بر مسدود کردن باتهای گوگل از خزیدن در URLهای بد، همچنین فکر خوبی است که از پیوند دادن به صفحاتی با کد وضعیت non-200 خودداری کنید.

برای جلوگیری از هدر دادن بودجه خزش، حتما از بخشهای مختلف وب سایت و محتواهای خود به صفحاتی پیوند دهید که URL فعال و ارجح شما هستند. به عنوان یک قاعده کلی، اگر یک URL مقصد نهایی محتوای شما نیست، باید از لینک دادن به آن خودداری کنید.

برای مثال، باید از پیوند دادن به موارد زیر اجتناب کنید:

- URLهای ریدایرکت شده

- نسخه غیرمتعارف (non-canonical) یک صفحه

- URLهایی که کد وضعیت 404 دارند.

بودجه خزش خود را با ارسال باتهای گوگل از طریق چند واسطه (که به زنجیرهها و حلقهها معروف است) برای یافتن محتوای خود هدر ندهید. در عوض، به مقصد نهایی پیوند دهید.

همچنین، از اشتباهات رایج نقشه سایت XML بپرهزید، مانند:

- فهرست کردن صفحات غیرقابل ایندکس مانند صفحات non-200، صفحات غیر متعارف، صفحات no-HTML و URLهای no-indexed

- فراموش کردن به روز رسانی نقشه سایت پس از تغییر URLها در حین انتقال سایت

- حذف صفحات مهم و موارد دیگر.

بسیار مهم است که در نقشه سایت خود فقط URLهای زنده و ارجح را قرار دهید و مراقب باشید که صفحات مهم و کلیدی خود را که میخواهید در گوگل ایندکس شوند اشتباها از قلم نیندازید. آیا صفحات محصول قدیمی و بیاستفاده دارید؟ حتما آنها را از نقشه سایت خود حذف کنید.

4- بررسی محدودیت نرخ خزیدن در Google Search Console

گوگل به شما این امکان را میدهد که نرخ خزیدن Googlebot را در سایت خود تغییر دهید. این ابزار میتواند بر محدودیت نرخ خزیدن شما تأثیر بگذارد که بخشی از نحوه تعیین بودجه خزش سایت شما توسط گوگل است، بنابراین درک آن بسیار مهم است.

اگرچه مجبور نیستید از این تابع استفاده کنید، اما اگر بخواهید مطابق با الگوریتم های گوگل نرخ خزش سایت خود را تعیین کنید، میتوانید با گوگل سرچ کنسول این کار را انجام دهید. اگر نرخ خزش خیلی زیاد باشد، خزیدن Googlebot ممکن است فشار زیادی به سرور شما وارد کند، به همین دلیل است که گوگل به مدیران وبسایتها امکان تعیین نرخ خزش محدود را میدهد. با این حال، این کار ممکن است باعث شود گوگل محتوای مهم شما را کمتر پیدا کند، بنابراین باید با احتیاط از آن استفاده کنید.

راه حل این موضوع چیست؟

نرخ خزش خود را در GSC (گوگل سرچ کنسول) تنظیم کنید. برای تنظیم نرخ خزش، به صفحه تنظیمات نرخ خزش و ویژگی مورد نظر خود بروید. دو گزینه را مشاهده خواهید کرد: «Let Google optimize» (به گوگل اجازه بهینه سازی بده) و «Limit Google’s maximum crawl rate» (حداکثر نرخ خرش گوگل را محدود کن). اگر میخواهید نرخ خزش سایت خود را افزایش دهید، بهتر است بررسی کنید و ببینید که آیا «Limit Google’s maximum crawl rate» به طور تصادفی انتخاب شده است یا خیر.

5- افزایش محبوبیت صفحات

Urlهایی که در اینترنت محبوبیت بیشتری دارند، بیشتر هم توسط گوگل کراول میشوند. یکی از راههایی که گوگل ممکن است محبوبیت یا حداقل اهمیت نسبی یک صفحه را قضاوت کند، مشاهده عمق آن صفحه است. عمق صفحه (یا "عمق کلیک") تعداد کلیکهایی است که برای رسیدن به یک صفحه از صفحه اصلی لازم است. هر چه تعداد این کلیکها بیشتر باشد (یعنی عمق صفحه بیشتر باشد)، خزش باتهای گوگل در آنها کمتر میشود.

یکی دیگر از نشانههای محبوبیت یک صفحه در یک سایت لینک سازی داخلی است. اگر به یک صفحه چندین بار پیوند داده شود، به این معنی است که آن صفحه محبوب است. به عبارت دیگر، صفحاتی که لینک بیشتری دریافت کریدهاند، بیشتر کراول میشوند.

راه حل این موضوع چیست؟

عمق صفحات را کاهش و لینکهای داخلی به صفحات مهم را افزایش دهید. برای اینکه به گوگل کمک کنید تا درک بهتری از اهمیت و محبوبیت صفحات شما داشته باشد، ایده خوبی است که صفحات مهم خود را به صفحه اصلی نزدیکتر کنید و همچنین بیشتر به آنها لینک دهید.

اگرچه نمیتوانید از صفحه اصلی سایت خود به هر صفحهای پیوند دهید، در مورد پیوندهای داخلی و معماری سایت خود با استراتژی عمل کنید. اگر صفحهای دارید که در سایت شما دفن شده است یا زیاد به آن پیوند نمیدهید، این احتمال وجود دارد که گوگل آن را کم اهمیتتر تلقی کند و کمتر در آن بخزد.

6- تازه کردن و به روز رسانی مطالب قدیمی و بدون بازدید

ممکن است گوگل دیگر یک صفحه را کراول نکند فقط به این دلیل که محتوای آن کهنه و منقضی شده است. اگر گوگل چند بار در سایت شما بخزد و تغییری در یک صفحه مشاهده نکند ممکن است دیگر آن را کراول نکند. گوگل میخواهد از کهنه شدن صفحات در فهرست خود جلوگیری کند.

یکی از راههای تشخیص اینکه آیا محتوای قدیمی در سایت خود دارید یا خیر، جداسازی پستهایی است که قبل از تاریخ خاصی منتشر شدهاند. برای مثال، اگر سرعت انتشار بسیار تهاجمی دارید (یعنی چندین پست در هر روز)، ممکن است بخواهید پستهای قدیمیتر از سه ماه را فیلتر کرده و مشاهده کنید. برای سایتهایی که کمتر محتوا منتشر میکنند، شاید این فرآیند برای پستهای قدیمیتر از سه سال کفایت کند. این فقط به معیار شما بستگی دارد.

علاوه بر این، میتوانید این فیلتر را با فیلتر «فعال/غیر فعال» جفت کنید. این کار به شما امکان میدهد تا تمام پستهای قدیمی را که ترافیک جستجوی ارگانیک دریافت نمیکنند مشاهده کنید.

راه حل این معضل چیست؟

محتوای قدیمی خود را به روز رسانی کنید. راه های زیادی وجود دارد که میتوانید محتوای قدیمی خود را به روز کنید، مثلا:

- هرگونه اطلاعات قدیمی را اصلاح کنید.

- اشتباهات املایی و دستور زبانی را بیابید و برطرف کنید.

- هر پیوند داخلی را که به منابع قدیمی ارجاع میدهد به روز کنید و در صورت لزوم پیوندهای جدید اضافه کنید.

- ببینید که یک صفحه برای چه پرس و جوهایی رتبه بندی میشود، بعد تحقیق کنید که با چه عبارات دیگری میتوانید رتبه آن صفحه را در SERP ارتقا دهید و بر اساس آن محتوای خود را به روز رسانی کنید.

مثالی از بهینه سازی بودجه خزش

یک وب سایت بزرگ فعال در بازار خودرو با یک مشکل بزرگ مواجه میشود و به گروه Botify مراجعه میکند - 99٪ از صفحات سایت آنها برای گوگل نامرئی بودند. قطعا این سایت به بهینه سازی بودجه خزش نیاز دارد!

تیم Botify با انجام دقیق مراحل زیر توانست بودجه خزش آنها را 19 برابر افزایش دهد:

- تمام صفحات موجود در ساختار این سایت را با باتهای Botify کراول کردند.

- فایلهای گزارش (Log Files) را ایمپورت کردند تا متوجه شوند گوگل کدام یک از آن صفحات را کراول نمیکند.

- تمام صفحات غیر قابل ایندکس در ساختار سایت را شناسایی کردند.

- فایل robots.txt را به روز رسانی کردند تا پس از انجام مرحله 2 از تلفات خزیدن جلوگیری کنند.

- پیوندهای داخلی را اصلاح کردند، عمق صفحات را کاهش دادند و ساختار خرده نان (breadcrumb structure) سایت را بازسازی کردند.

- نقشه سایت را طوری بهروزرسانی کردند که فقط URLهای قابل ایندکس را شامل شود.

بهبود خزش میتواند درآمد شما را بهبود ببخشد

استفاده از روشهای بهینهسازی بودجه خزش که در این مقاله ذکر شد، حتی در سایتی که میلیونها صفحه دارد، میتواند فرصتهای فراوانی ایجاد کند - هم برای بودجه خزش، هم برای افزایش ترافیک سایت و هم برای افزایش درآمد شما از وب سایتتان!

قواعد قیف سئو نشان میدهد که بهبود مرحله خزش برای سطوح پایین دستی مثل مراحل رتبه بندی، ترافیک و درآمد نیز مزیت ایجاد میکند. بودجه خزش فقط یک چیز فنی و تکنیکال نیست، بلکه روی درآمد شما تاثیر میگذارد. بنابراین سعی کنید باتها و بازدیدکنندگان را فقط به سمت چیزهای خوب هدایت کنید!

اگر نیاز به مشاوره و راهنمایی بیشتری دارید، کارشناسان ما در آژانس دیجیتال مارکتینگ منتاپلاس در خدمت شما هستند.

منبع: https://www.botify.com/